新網(wǎng)站建設為什么需要加robot文件?有什么作用?

時間:2021-08-02來源:網(wǎng)騎士

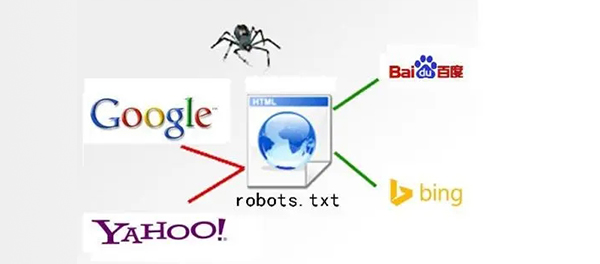

robot文件,它的作用是搜索引擎抓取程序蜘蛛,自動訪問互聯(lián)網(wǎng)上的網(wǎng)頁并獲取網(wǎng)頁信息,如果需要限制搜索引擎抓取,也可以在robot文件中設置,限制后該搜索引擎就不會抓取網(wǎng)站,信息也不會被泄露,大大提高了網(wǎng)站后臺和用戶信息的安全系數(shù)。

看到這里,想必大家對robot文件有了更為深刻的認識,那么如何編輯robot文件呢?下面深圳網(wǎng)站建設為大家簡單介紹一下robot文件的編輯規(guī)則。

第一,robots.txt首行必寫User-agent,它是用于定位搜索引擎的蜘蛛類型。常見的蜘蛛類型如:谷歌蜘蛛googlebot,百度蜘蛛baidusoider,騰訊蜘蛛sosospider,搜狗蜘蛛sogouspider,360蜘蛛360spider……如果你想讓所有的蜘蛛都可以來抓取那么我們可以用*來表示,意為說是有蜘蛛。

第二,robots.txt禁止抓取命令Disallow,我們可以用改命令來屏蔽抓取。常見的屏蔽操作有屏蔽js css,屏蔽動態(tài)路徑,屏蔽tag標簽,屏蔽低質(zhì)量頁面,屏蔽模板、插件文件等等,這些屏蔽內(nèi)容都是為了將資源權(quán)重傳遞給網(wǎng)站參與排名的網(wǎng)頁。

第三,robots.txt允許抓取命令Allow,其實一般情況下,如果我們吧設置允許抓取命令,那么搜索引擎蜘蛛默認就是允許抓取,所以這里我們就不再多做解釋。

第四,robots.txt文件書寫時還有很多需要我們注意的地方,如通配符“*”的使用,終止符“$”運用,最為重要的是,當我們書寫robots.txt文件時一定要注意,我們的書寫格式要定義在英文格式下,否則是不被識別的。

將robots.txt文件完成后,要將其傳入我們的網(wǎng)站的根目錄中,然后通過站長工具如,百度站長,站長之家等將robots文件進行提交檢測,我們的robots文件才算正在完成。

這里還要提醒大家一下,雖然robots.txt文件有屏蔽作用,但是最好不要采取全站屏蔽,因為屏蔽是有時效的,釋放也是有時效,所以全站屏蔽這種操作往往會耽誤我們的網(wǎng)站優(yōu)化。

相關資訊

-

深圳建設網(wǎng)站公司找哪家好隨著互聯(lián)網(wǎng)的發(fā)展,網(wǎng)站建設如雨后春筍般瘋狂增長,在搜索引擎搜索深圳網(wǎng)站建設前十頁...2021-08-12

-

模板建站缺點你了解多少?互聯(lián)網(wǎng)發(fā)展至今,線上競爭越來越激烈,很多企業(yè)的思維還沒轉(zhuǎn)變,想著低價做個模板網(wǎng)站...2021-08-05

-

網(wǎng)站建設如何分析網(wǎng)站問題網(wǎng)站建設好后并不代表著就可以坐等客戶了,網(wǎng)站上線后的網(wǎng)站SEO優(yōu)化也是至關重要的...2021-08-04

-

新網(wǎng)站建設為什么需要加robot文件?有什么作用?robot文件,它的作用是搜索引擎抓取程序蜘蛛,自動訪問互聯(lián)網(wǎng)上的網(wǎng)頁并獲取網(wǎng)頁...2021-08-02

-

新網(wǎng)站建設內(nèi)部鏈接優(yōu)化策略現(xiàn)在很多做網(wǎng)站優(yōu)化都有個誤區(qū),都把精力放到了外鏈上,很少有人注意到內(nèi)鏈的作用,內(nèi)...2021-07-31

-

新網(wǎng)站建設如何更快被百度收錄?有的客戶剛上線隔天就被收錄,有的客戶上線好久一直未被收錄,深圳網(wǎng)站建設小編曾也碰...2021-07-29

-

網(wǎng)站排名優(yōu)化多久能出上首頁經(jīng)常聽到SEO圈子里人說,做一個月兩個月網(wǎng)站沒排名,沒咨詢,沒什么效果,老板給了...2021-07-28

-

深圳網(wǎng)站建設哪家公司性價比高深圳網(wǎng)站建設哪家公司性價比高?所有企業(yè)都有一個通病,就是想花幾千甚至幾百的價格建...2021-07-27

掃碼合作

掃碼合作 微信公眾號

微信公眾號

技術(shù)部:廣東省深圳市龍崗區(qū)盛龍路60號和中心12樓

官網(wǎng):www.sogyw.cn

官網(wǎng):www.sogyw.cn 郵箱:sales@cnrider.com

郵箱:sales@cnrider.com  專線:18675537858

專線:18675537858

0755-28828820

0755-28828820 郵箱:sales@cnrider.com

郵箱:sales@cnrider.com